شاید درباره خزیدن وب شنیده باشید و تا حدودی با مفهوم آن آشنا باشید،

اما آیا میدانید چرا مهم است و چه تفاوتی با وب کراولینگ دارد؟

موتورهای جستجو روز به روز سختگیرتر میشوند و فقط سایتهای باکیفیت را در نتایج جستجو نمایش میدهند.

اگر اصول بهینهسازی برای خزندههای وب (و در نهایت کاربران) را ندانید، ممکن است ترافیک ارگانیک سایتتان آسیب ببیند.

یک خزنده وب خوب میتواند به شما کمک کند تا دیده شدن سایتتان را حفظ کنید و حتی بهبود دهید.

در ادامه، هر آنچه باید درباره خزندههای وب و خزندههای سایت بدانید را بررسی میکنیم.

خزنده وب چیست؟

خزنده وب یک برنامه یا اسکریپت نرمافزاری است که به صورت خودکار در اینترنت جستجو میکند، صفحات وب را تحلیل کرده و آنها را فهرستبندی میکند.

این خزندهها که با نامهایی مانند وب اسپایدر یا اسپایدر بات نیز شناخته میشوند، محتوای یک صفحه را بررسی میکنند تا تصمیم بگیرند چگونه آن را در فهرست خود اولویتبندی کنند.Googlebot، خزنده وب گوگل، با دقت در اینترنت پیمایش میکند، از طریق لینکها از صفحهای به صفحه دیگر میرود، دادهها را جمعآوری کرده و محتوای صفحات را برای نمایش در موتور جستجوی گوگل پردازش میکند.

تأثیر خزندههای وب بر سئو چیست؟

خزندههای وب صفحات شما را بررسی کرده و تعیین میکنند که چقدر قابل فهرستبندی و رتبهبندی هستند، که در نهایت روی میزان ترافیک ارگانیک سایت شما تأثیر میگذارد.

اگر میخواهید در نتایج جستجو دیده شوید، باید محتوای خود را برای خزیدن و فهرستبندی آماده کنید.

انواع مختلف خزندههای وب چیست؟

خزندههای وب انواع مختلفی دارند. برخی مانند Googlebot و Bingbot وظیفه دارند میلیاردها صفحه را بهطور مداوم بررسی کنند تا نتایج جستجو بهروز بماند.

در کنار آنها، خزندههای تخصصیتری هم وجود دارند، مانند:

-

خزندههای سایت که برای بررسی مشکلات فنی یک وبسایت استفاده میشوند.

-

خزندههای دانشگاهی که مقالات پژوهشی را جستجو میکنند.

-

وب اسکرپرهای بصری که به کاربران بدون دانش کدنویسی اجازه میدهند دادههای مورد نیازشان را از وب جمعآوری کنند.

در این مقاله، تمرکز اصلی ما روی خزندههای وب و خزندههای سایت خواهد بود.

خزندههای وب چگونه کار میکنند؟

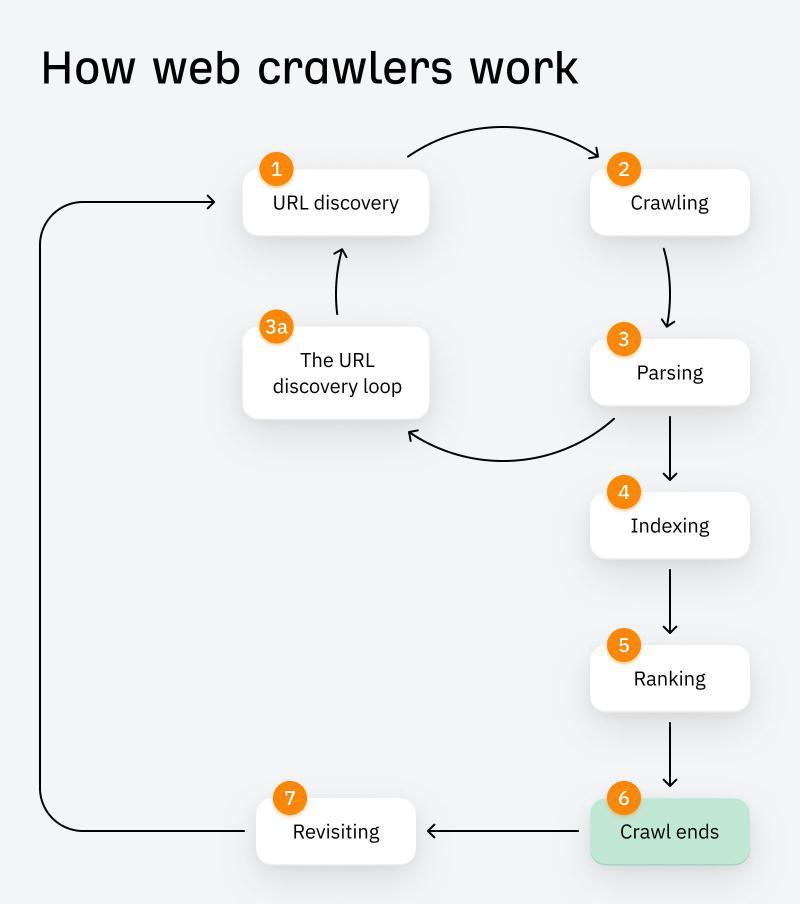

فرآیند خزیدن وب در حدود هفت مرحله انجام میشود:

1. کشف URL

هنگامی که یک صفحه جدید منتشر میکنید (مثلاً در نقشه سایت)، خزنده وب آن را شناسایی کرده و بهعنوان یک URL اولیه در نظر میگیرد. این URLهای اولیه، مانند بذر در فرآیند رشد گیاه، باعث آغاز خزیدن و ادامه این چرخه میشوند.

2. خزیدن (Crawling)

پس از کشف URL، صفحه شما برای خزیدن زمانبندی میشود. در این مرحله، محتوای صفحه شامل متا تگها، تصاویر، لینکها و دادههای ساختاریافته دانلود و در سرورهای موتور جستجو ذخیره میشود.

3. تحلیل و پردازش (Parsing)

خزنده دادههای جمعآوریشده را تحلیل میکند تا تصمیم بگیرد چگونه صفحه را فهرستبندی و رتبهبندی کند.

4. حلقه کشف URL

در حین پردازش، خزنده لینکهای جدیدی را که در صفحه یافت میشود (از جمله لینکهای ناشی از ریدایرکتها) شناسایی کرده و به صف URLهای جدید برای بازدید اضافه میکند. این فرآیند دوباره از مراحل 1 تا 3 تکرار میشود.

5. فهرستبندی (Indexing)

درحالیکه لینکهای جدید کشف میشوند، URL اصلی در فهرست موتور جستجو ثبت میشود. این کار باعث میشود که موتورهای جستجو بتوانند نتایج مرتبط را سریعتر برای جستجوهای کاربران بازیابی کنند.

6. رتبهبندی (Ranking)

صفحات فهرستشده براساس کیفیت، میزان ارتباط با کوئریهای جستجو و سایر عوامل رتبهبندی امتیازدهی شده و در نتایج جستجو نمایش داده میشوند.

7. پایان خزیدن

سرانجام، فرآیند خزیدن بر اساس زمان اختصاصیافته، تعداد صفحات خزیدهشده، و عمق لینکهای دنبالشده به پایان میرسد.

8. بازبینی مجدد (Revisiting)

خزندهها هر از گاهی دوباره به صفحه بازمیگردند تا بهروزرسانیها، محتوای جدید یا تغییرات ساختاری را بررسی کنند.

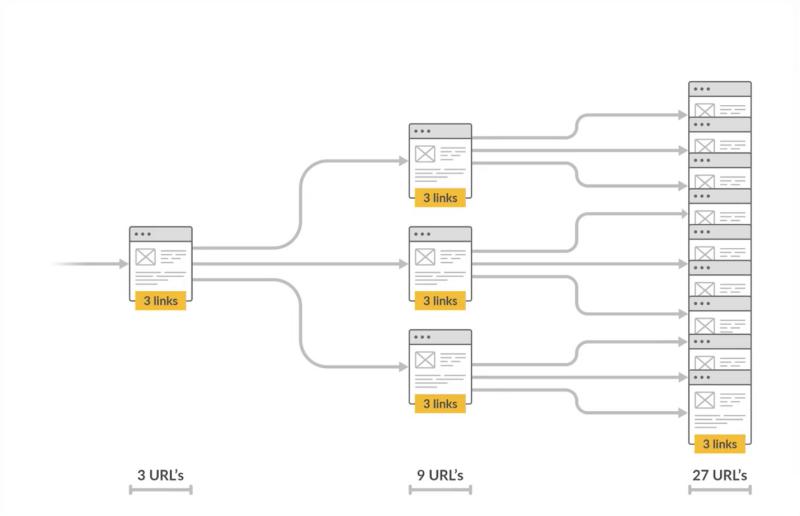

همانطور که احتمالاً حدس میزنید، تعداد URLهایی که در این فرآیند کشف و خزیده میشوند، تنها پس از چند مرحله بهصورت تصاعدی افزایش مییابد.

چگونه میتوانید موتورهای جستجو را وادار کنید که سایت شما را خزیده و ایندکس کنند؟

رباتهای خزنده موتور جستجو خودکار هستند، یعنی نمیتوانید مستقیماً آنها را فعال یا غیرفعال کنید.

با این حال، میتوانید با این روشها به آنها کمک کنید:

1. نقشه سایت XML

نقشه سایت XML فایلی است که تمام صفحات مهم وبسایت شما را فهرست میکند تا موتورهای جستجو بتوانند محتوای شما را راحتتر کشف و ایندکس کنند.

2. ابزار بررسی URL گوگل

میتوانید از طریق ابزار InspectURL در گوگل سرچ کنسول درخواست خزیدن مجدد محتوای سایت خود را بدهید. اگر گوگل URL شما را شناسایی کرده اما هنوز آن را ایندکس نکرده است، ممکن است در GSC پیامی دریافت کنید. در این صورت، باید مشکل "Discovered — currently not indexed" را برطرف کنید.

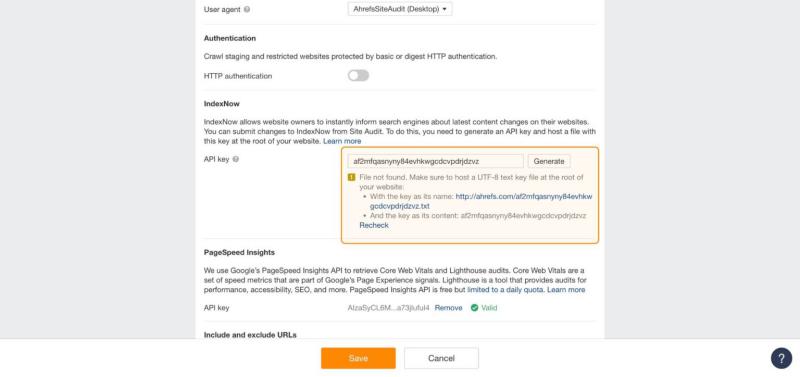

3. IndexNow

بهجای انتظار برای خزیدن مجدد رباتها، میتوانید از IndexNow برای اطلاعرسانی خودکار به موتورهای جستجو مانند بینگ، یاندکس، ناور، Seznam.cz و Yep استفاده کنید، هر زمان که:

-

صفحات جدید اضافه کنید

-

محتوای موجود را بهروزرسانی کنید

-

صفحات قدیمی را حذف کنید

-

ریدایرکتها را اجرا کنید

میتوانید ارسال خودکار درخواستهای IndexNow را از طریق Ahrefs Site Audit تنظیم کنید.

چگونه گوگل را وادار کنیم که صفحات بیشتری از سایت ما را بیشتر خزیده و ایندکس کند

تصمیمات گوگل برای خزیدن صفحات پویا و تا حدی نامشخص هستند.

با اینکه دقیقاً نمیدانیم گوگل بر چه اساسی زمان و دفعات خزیدن صفحات را تعیین میکند، اما بر اساس مستندات و مصاحبههای رسمی، سه عامل کلیدی را شناسایی کردهایم:

1. اولویت دادن به کیفیت

الگوریتم PageRank گوگل تعداد و کیفیت لینکهای ورودی به یک صفحه را بررسی میکند و آنها را بهعنوان "رأیهای" اعتبار در نظر میگیرد.

صفحات با لینکهای باکیفیت، مهمتر تلقی شده و در نتایج جستجو رتبه بالاتری میگیرند.

از آنجا که PageRank بخش مهمی از الگوریتم گوگل است، کیفیت لینکها و محتوای شما در نحوه خزیدن و ایندکس شدن سایت شما تأثیر زیادی دارد.

برای سنجش کیفیت سایت شما، گوگل این فاکتورها را در نظر میگیرد:

-

لینکهای داخلی

-

لینکهای خارجی

-

تجربه کاربری صفحه

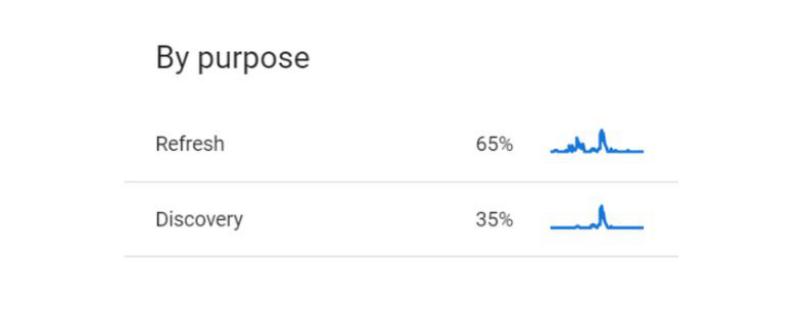

2. محتوا را تازه نگه دارید

طبق گفتهی جان مولر، تحلیلگر ارشد جستجوی گوگل:

موتورهای جستجو برخی URLها را چندین بار در روز و برخی دیگر را فقط هر چند ماه یکبار خزیده و بهروزرسانی میکنند.

بنابراین، اگر میخواهید گوگل بیشتر به سایت شما سر بزند، بهروزرسانی منظم محتوا یک عامل مهم است.

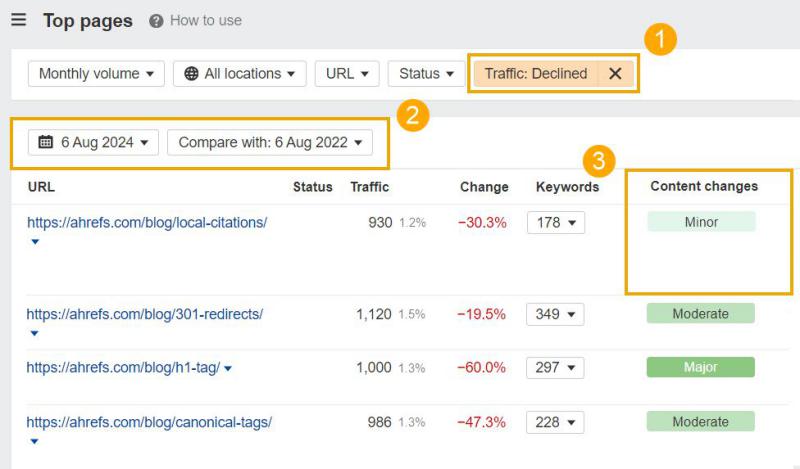

برای پیدا کردن صفحات خاصی که نیاز به بهروزرسانی دارند، به گزارش Top Pages در Ahrefs Site Explorer بروید و سپس:

-

فیلتر ترافیک را روی "Declined" (کاهشیافته) تنظیم کنید.

-

محدوده تاریخ را به یک یا دو سال گذشته تغییر دهید.

-

به وضعیت "Content Changes" (تغییرات محتوا) نگاه کنید و صفحاتی را که فقط تغییرات جزئی داشتهاند، بهروزرسانی کنید.

گزارش Top Pages محتوایی را که بیشترین ترافیک ارگانیک را به سایت شما جذب میکند، نمایش میدهد. با بهروزرسانی این صفحات، میتوانید خزندههای موتور جستجو را تشویق کنید تا بیشتر به محتوای برتر شما سر بزنند و (امیدواریم) ترافیک در حال کاهش را بهبود ببخشید.

گزارش Top Pages صفحاتی را که بیشترین ترافیک ارگانیک را به سایت شما جذب میکنند، نمایش میدهد. با بهروزرسانی این صفحات، میتوانید خزندههای موتور جستجو را تشویق کنید تا بیشتر به محتوای برتر شما سر بزنند و (امیدواریم) ترافیک کاهشیافته را بازیابی کنید.

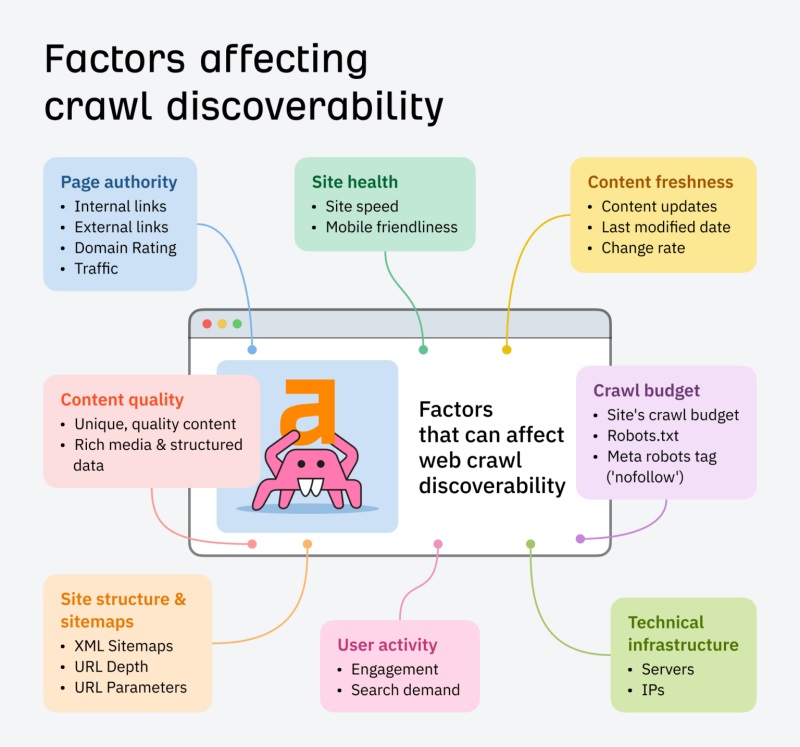

بودجه خزیدن (Crawl Budget) چیست؟

خزندههای وب رفتار کاربران انسانی را شبیهسازی میکنند. هر بار که به یک صفحه وب سر میزنند، سرور سایت یک درخواست دریافت میکند. اگر صفحات سایت برای خزیدن دشوار باشند، خطاها و زمان بارگذاری طولانی ایجاد میشود. همچنین، اگر یک خزنده بیش از حد به یک صفحه سر بزند، ممکن است سرور یا مدیر وب آن را به دلیل مصرف زیاد منابع مسدود کند.

به همین دلیل، هر سایت یک بودجه خزیدن دارد که نشاندهنده تعداد URLهایی است که یک خزنده میتواند و مایل است آنها را بررسی کند. عواملی مانند سرعت سایت، سازگاری با موبایل و ساختار منطقی سایت بر کارایی بودجه خزیدن تأثیر میگذارند.

وبسایت کراولر چیست؟

خزندههای وب مانند Googlebot کل اینترنت را بررسی میکنند و شما کنترلی بر اینکه کدام سایتها را بازدید میکنند یا چند وقت یکبار این کار را انجام میدهند، ندارید.

اما وبسایت کراولرها به شما امکان میدهند که خزندههای خصوصی خود را داشته باشید.

با استفاده از این ابزارها، میتوانید سایت خود را برای یافتن و رفع مشکلات SEO بررسی کنید یا سایت رقیب را تحلیل کنید و از نقاط ضعف آنها به نفع خود بهره ببرید.

وبسایت کراولرها عملکرد موتورهای جستجو را شبیهسازی میکنند و به شما کمک میکنند تا بفهمید یک موتور جستجو چگونه صفحات شما را میبیند، بر اساس عواملی مانند:

✅ ساختار سایت

✅ محتوا

✅ متا دیتا

✅ سرعت بارگذاری صفحات

✅ خطاها و مشکلات فنی

و ..

نمونهای از وبسایت کراولر:Ahrefs Site Audit

خزنده Ahrefs Site Audit ابزارهای Rank Tracker، Projects و Site Audit را پشتیبانی میکند و به متخصصان سئو کمک میکند تا:

✅ بیش از ۱۷۰ مشکل فنی سئو را تجزیه و تحلیل کنند.

✅ خزیدن آنی سایت را با دادههای زنده از عملکرد سایت انجام دهند.

✅ تا ۱۷۰ هزار URL در دقیقه را بررسی کنند.

✅ مشکلات فنی را رفع کرده و دیده شدن سایت را در موتورهای جستجو بهبود ببخشند.

تفاوت وبسایت کراولر با وب کراولر این است که بهجای ایندکس و رتبهبندی صفحات در موتورهای جستجو، آنها را در پایگاه داده خود ذخیره و تحلیل میکند.

دو روش خزیدن سایت:

لوکال (Local): ابزارهایی مثل Screaming Frog به شما امکان میدهند خزیدن سایت را روی کامپیوتر خود دانلود و شخصیسازی کنید.

ابری (Cloud-Based): ابزارهایی مثل Ahrefs Site Audit بدون استفاده از منابع سیستم شما، سایت را تحلیل کرده و امکان کار تیمی برای بهینهسازی سایت را فراهم میکنند.

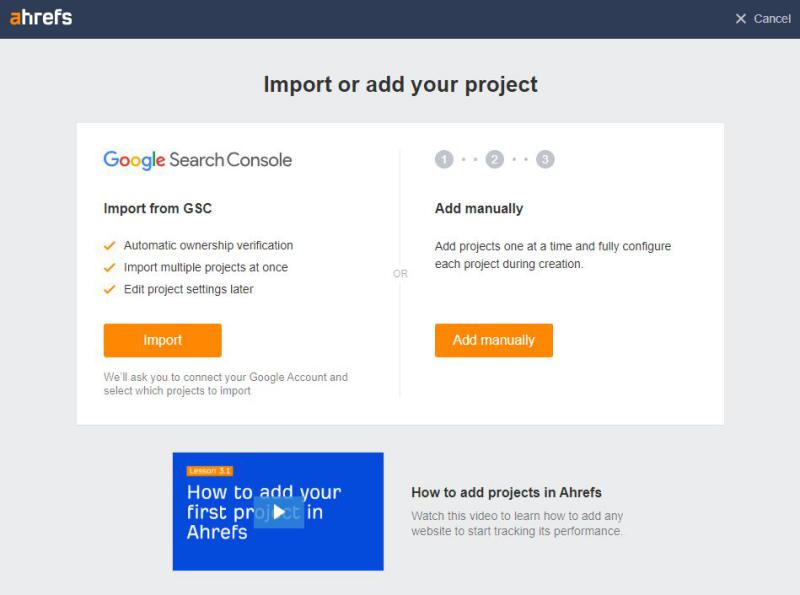

چگونه وبسایت خود را کراول کنیم؟

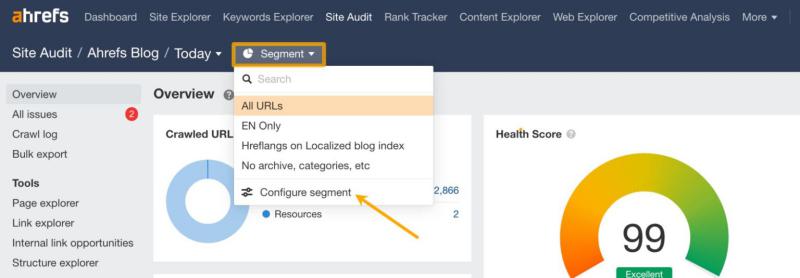

اگر میخواهید وبسایت خود را در لحظه اسکن کنید و مشکلات فنی سئو را شناسایی کنید، میتوانید یک خزش (Crawl) را در Site Audit تنظیم کنید.

این ابزار به شما تحلیلهای تصویری، امتیاز سلامت سایت، و پیشنهادات دقیق برای رفع مشکلات ارائه میدهد تا بفهمید موتورهای جستجو چگونه سایت شما را تفسیر میکنند.

1. تنظیم خزش سایت

🔹 به تب Site Audit بروید و یک پروژه موجود را انتخاب کنید یا یک پروژه جدید ایجاد کنید.

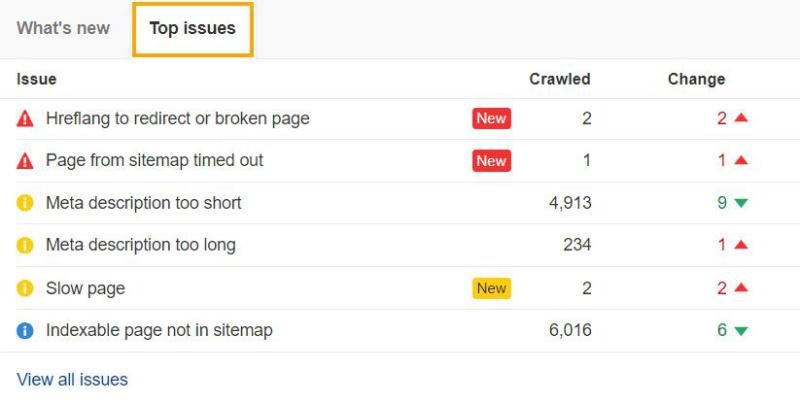

2. شناسایی خطاهای مهم

🔹 گزارش "Top Issues" در Site Audit مهمترین خطاها، هشدارها و نکات قابل توجه را بر اساس تعداد URLهای تحت تأثیر نمایش میدهد.

چرا مهم است؟

✅ به شما کمک میکند مشکلات فنی را که بیشترین تأثیر را بر سئوی سایت دارند، به سرعت شناسایی کنید.

✅ راهکارهای پیشنهادی برای رفع هر مشکل ارائه میدهد.

پس از بررسی خطاهای اصلی، میتوانید روی بهینهسازی سایت خود تمرکز کنید تا عملکرد آن در موتورهای جستجو بهبود یابد.

بررسی و بهبود سئو با Site Audit

✅ 1. شناسایی خطاهای مهم (آیکون قرمز)

🔹 مشکلاتی که مانع خزیدن و ایندکس شدن سایت میشوند، مانند:

-

خطاهای HTTP و کلاینت (۴۰۴، ۵۰۰ و غیره)

-

لینکهای شکسته

-

مشکلات مربوط به تگ canonical

✅ 2. بهینهسازی محتوا و رتبهبندی (آیکون زرد)

🔹 مواردی که بر تجربه کاربر و سئو تأثیر میگذارند، مانند:

-

نبودن متن جایگزین (alt) برای تصاویر

-

لینکهایی که به صفحات ریدایرکتشده اشاره میکنند

-

توضیحات متا خیلی طولانی

✅ 3. حفظ دیده شدن سایت (آیکون آبی)

🔹 مواردی که ممکن است تأثیر تدریجی بر سئو داشته باشند، مانند:

-

افت ترافیک ارگانیک

-

وجود چندین تگ H1 در یک صفحه

-

صفحات ایندکسشدهای که در Sitemap نیستند

✅ 4. چگونه مشکلات را اولویتبندی کنیم؟

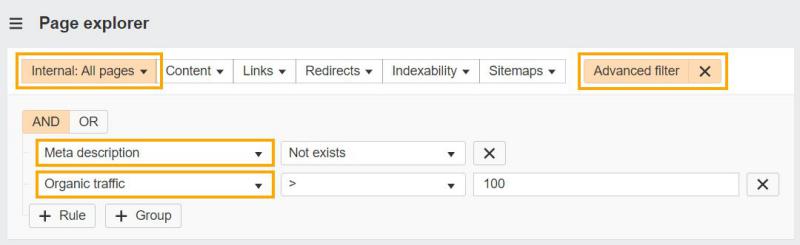

🔹مثلاً اگر هزاران صفحه بدون توضیحات متا دارید، میتوانید ابتدا روی صفحات با ترافیک بالا تمرکز کنید:

1. به گزارش Page Explorer در Site Audit بروید.

2. گزینه فیلتر پیشرفته را انتخاب کنید.

3. فیلتر صفحات داخلی را تنظیم کنید.

4. عملگر "And" را انتخاب کنید.

5. گزینههای "Meta description" و "Not exists" را انتخاب کنید.

6. مقدار Organic traffic > 100 را تنظیم کنید.

نتیجه؟ شما روی مهمترین صفحات تمرکز میکنید و سریعتر تأثیر بهتری روی سئو میگذارید!

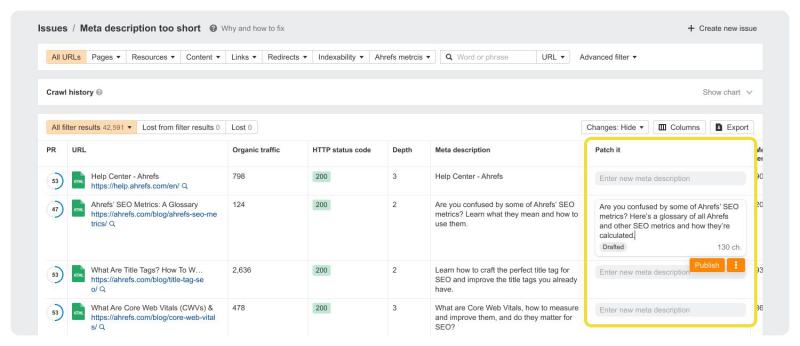

3. رفع سریع مشکلات

🔹 کدنویسی بلد نیستید؟ نگران نباشید! بررسی سایت و اعمال تغییرات ممکن است دلهرهآور باشد، اما نیازی به دانش فنی عمیق ندارید.

🔹 تیم فنی دارید؟ عالی! اما زمان آنها محدود است و برای رفع مشکلات باید اولویتبندی کنید.

✅ راهحل: ویژگی جدید "Patches" در Site Audit

با Patches میتوانید برخی از مشکلات را بدون نیاز به توسعهدهنده برطرف کنید و سایت را سریعتر بهینه کنید.

نتیجه؟ مشکلات را زودتر حل کنید، سرعت سایت را بالا ببرید و عملکرد سئوی خود را بهبود دهید!

اصلاح سریع مشکلات سایت بدون نیاز به برنامهنویس!

✅ مشکلاتی مثل:

🔹 تغییر عنوان صفحات

🔹 توضیحات متا از دست رفته

🔹 لینکهای شکسته در سراسر سایت

راهحل ساده: با دکمه "Patch it" میتوانید این مشکلات را مستقیماً در سایت خود اصلاح کنید – بدون نیاز به درخواست از تیم فنی!

نگران تغییرات هستید؟ در هر زمان که بخواهید، میتوانید تغییرات را بازگردانی (Rollback) کنید.

4. شناسایی فرصتهای بهینهسازی

بررسی سایت با یک خزنده وب فقط برای رفع مشکلات نیست، بلکه فرصتی عالی برای بهینهسازی سایت هم محسوب میشود.

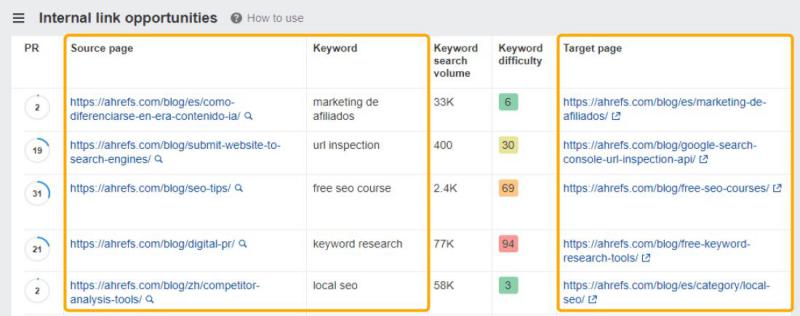

بهبود لینکسازی داخلی

گزارش Internal Link Opportunities در Site Audit به شما پیشنهادهای لینکسازی داخلی هوشمند را نشان میدهد.

چگونه کار میکند؟

✅ این ابزار ۱۰ کلمه کلیدی برتر هر صفحه (بر اساس ترافیک) را بررسی میکند.

✅ سپس صفحات دیگر سایت شما را جستجو کرده و محلهایی که این کلمات ذکر شدهاند را شناسایی میکند.

✅ در نهایت، به شما پیشنهاد میدهد که از صفحات "مبدأ" به صفحات "مقصد" لینک دهید تا ساختار لینکسازی داخلی شما قویتر شود.

نتیجه؟ افزایش ارتباط بین صفحات، بهبود تجربه کاربری، و در نهایت رشد رتبهبندی سایت در موتورهای جستجو!

اتصالات قویتر = خزیدن بهتر

هرچه اتصالات باکیفیتتری بین محتوای خود ایجاد کنید، خزندههای موتور جستجو مانند Googlebot راحتتر میتوانند سایت شما را بررسی و ایندکس کنند.

جمع بندی

درک فرآیند خزیدن وبسایت فقط یک ترفند سئو نیست، بلکه دانشی بنیادی است که بهطور مستقیم روی ترافیک و بازگشت سرمایه (ROI) شما تأثیر میگذارد.

وقتی بدانید خزندهها چطور کار میکنند، در واقع میدانید موتورهای جستجو چگونه سایت شما را میبینند و این یعنی نیمی از مسیر موفقیت در رتبهبندی را طی کردهاید!